LLM에서 많이 사용되는 P-tuning, Prefix-tuning, Prompt-tuning 이렇게 세 가지 tuning에 대해 잘 정리해놓은 YouTube 영상이 있어서 한번 보고 시작하면 이해하기 쉽다.

이 세가지 tuning기법은 2021년에 등장했기 때문에 P* tuning 이라고 불리움. continuous prompt를 task에 맞춰 optimizing하는 기법들이다.

[IJCNLP'21] Prefix-Tuning: Optimizing Continuous Prompts for Generation

Related works

이 세가지 기법을 모아 P* tuning이라고도 불리움.

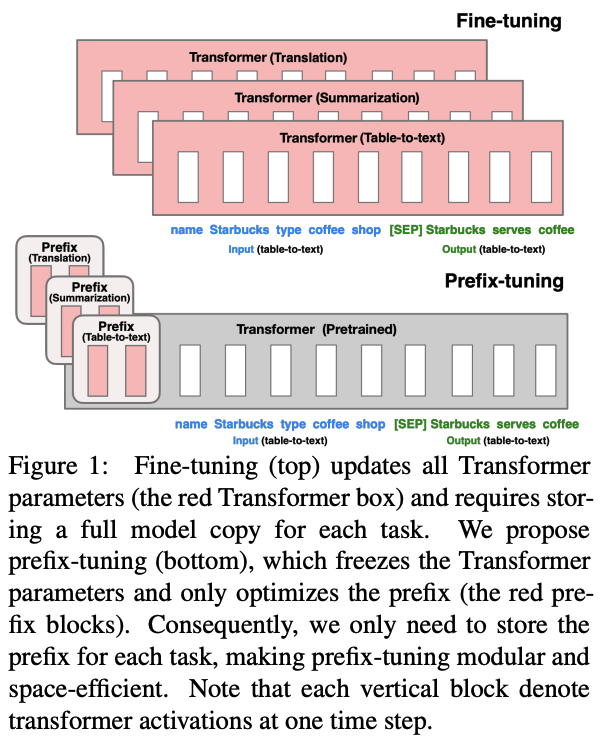

본 논문 Motivation은 pretrained 된 파라미터를 보존하면서 Prefix의 학습만 가지고 다양한 task 에 대해 adapter역할을 하도록 할 수 있는지 확인하고 싶은게 목적이었음.

Method

prefix-tuning은 Pretrained 된 transformer 는 freeze하되 task 별로 들어갈 prefix input (prompt) 만을 다음과 같이 학습하는 방법.

참고사항으로 직접적으로 prefix를 학습하는 방법은 optimization이 불안정하고 성능을 떨어뜨렸다고 한다.*따라서 저자들은 MLP(큰 feedforward neural network)로 구성된 더 작은 matrix로 기존 prefix matrix를 reparametrize했음

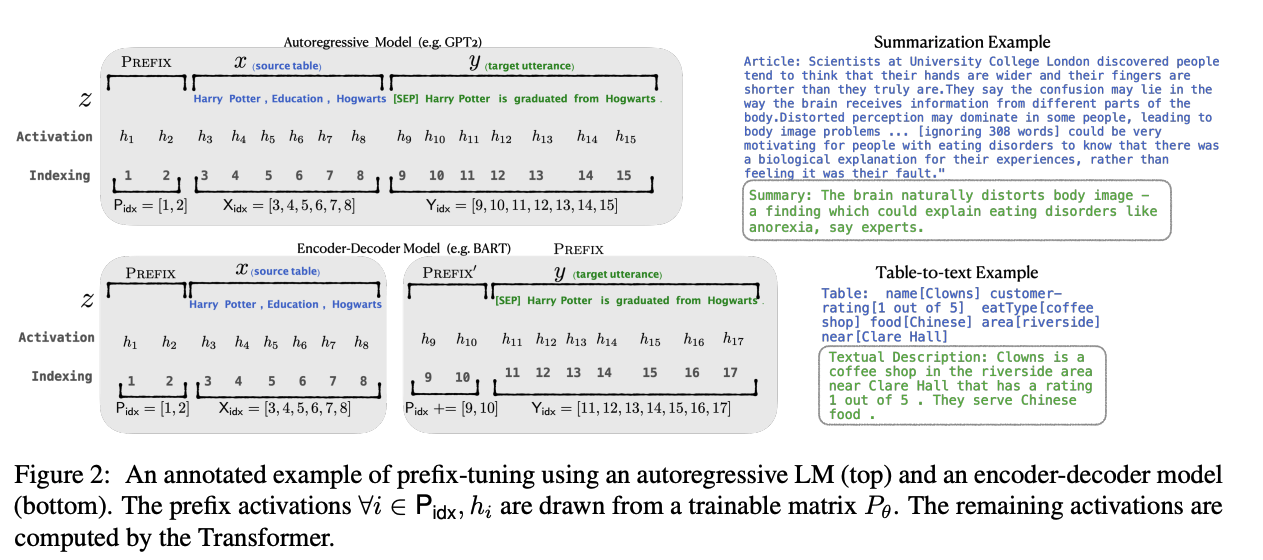

다음과 같이 두가지 transformer 구조에 적용을 하는 과정을 도식화 함.

- GPT와 같은 Auto Regressive 모델. 즉, transformer decoder만 사용

- Seq2Seqd와 같이 transformer encoder와 decoder가 둘다 input을 받기 때문에 prefix 도 양쪽으로 넣어줌.

Experiment

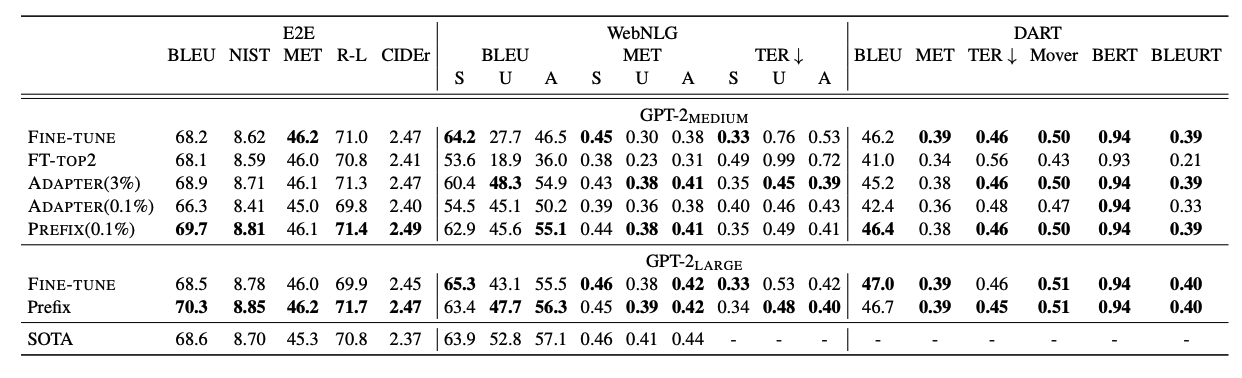

다음과 같이 Fune-tuning 보다 오히려 좋은 성능을 보일때도 있으며 adapter방법들 대비 성능이 우수함.